Vous ouvrez un roman. Devant vos yeux, des lettres, des mots, des paragraphes, des chapitres. Derrière les lettres, derrière les mots ? Faites l’exercice, interrompez la lecture, si possible alors que vous êtes plongé dans un passage palpitant, lisant un auteur qui vous donne la sensation de vous immerger dans son monde. Que voyez-vous ? Des images ? Des lieux, des personnes, des objets ? Des couleurs, des textures ? Des sensations ? Des abstractions ?

Répondre est difficile, car comme l’écrivait Peter Mendelsund en 2015, « quand nous discutons de la sensation que procure la lecture, nous sommes en réalité, déjà, en train de parler du souvenir de cette expérience. Et ce souvenir est un faux souvenir ». Peter Mendelsund est essayiste, graphiste, directeur artistique dans de prestigieuses maisons d’édition et pour le journal The Atlantic. Il s’est emparé, il y a un peu plus de dix ans, de la question : « Que voit-on quand on lit ? », qui a donné son titre à l’ouvrage. Et ses réflexions d’alors éclairent d’un jour inattendu une récente avancée dans le domaine de l’intelligence artificielle…

Avec ce livre inclassable, qui mêle réflexions personnelles, extraits d’échanges avec des chercheurs et des lecteurs et, surtout, de nombreuses illustrations, on plonge au cœur du mystère de la lecture et l’on se convainc que « les mots ne sont pas tant utiles par le sens qu’ils portent que par leur potentiel à solliciter l’expérience des lecteurs ». Prenons simplement la manière dont nous nous représentons un personnage principal. Comme l’observe avec force exemples Peter Mendelsund, les caractéristiques d’un personnage, telles que les distille un auteur au fil du texte, aident à en préciser les contours, mais pas à en faire un portrait intégral. Celui-ci sera, toujours, issu de nos souvenirs, des visages que nous connaissons. Et l’essayiste de conclure que « les auteurs opèrent une réduction du monde quand ils écrivent, et les lecteurs opèrent une autre réduction quand ils lisent. Le cerveau lui-même est construit de manière à réduire, remplacer, modéliser. Se représenter une histoire, c’est faire des réductions. Et c’est ainsi que nous produisons du sens ».

Que se passe-t-il quand une IA lit ? Le principe général de fonctionnement des modèles massifs de langage (LLM) est assez simple : il consiste à prolonger des morceaux de textes, appelés « prompts » ou « invites », de la manière jugée la plus probable par un réseau de neurones entraîné sur une grande quantité de données. L’apprentissage consiste à analyser des textes, à les découper en tokens (des mots ou des morceaux de mots), puis à mesurer la probabilité d’occurrence de chaque token T à la suite de séries de tokens {Ti}. Ainsi, lors de l’apparition de la suite {Ti} il sera possible de proposer un token T suivant (le plus probable, le plus plausible…). Dans le cadre d’un chatbot s’appuyant sur un LLM, le prompt est constitué de quelques lignes soigneusement rédigées par des ingénieurs spécialisés – et auxquelles les utilisateurs n’ont pas accès – et d’une partie de l’historique de la conversation entre l’internaute et le chatbot. Pour formuler des réponses correctes aux questions qui lui sont posées, le LLM exploite une connaissance statistique de nombreux textes liés à la requête et de ce que sont des phrases correctes dans la langue de son interlocuteur. Cela donne au robot conversationnel la capacité de créer des phrases nouvelles auxquelles nous donnons du sens, des réponses précises et cohérentes, le plus souvent bien informées, qui suggèrent la compréhension d’une multitude de sujets.

En résumé : la machine ne lit pas. La lecture par l’IA n’est pas une expérience vécue. Et l’IA ne produit pas de sens : c’est l’utilisateur qui s’en charge. Cela reste cependant très efficace, convaincant, tant que la conversation avec le robot n’excède pas une certaine limite. La « fenêtre de contexte » désigne la quantité maximale d’information textuelle qu’un modèle de langage peut prendre en compte en une seule fois pour produire une réponse. Elle inclut les messages précédents de la conversation (questions et réponses), les instructions système, et le texte de la requête courante. Pour les grands modèles récents, cette fenêtre correspond à plusieurs dizaines de milliers de tokens. Cela correspond typiquement à plusieurs dizaines de pages de texte continu, ou des conversations longues, de l’ordre de quelques dizaines de milliers de mots cumulés.

C’est déjà beaucoup… mais les modèles actuels sont confrontés à une limite : la capacité de calcul nécessaire évoluant de manière quadratique, il est déraisonnable d’étendre la fenêtre de contexte en misant sur la seule puissance de calcul. À titre d’illustration, utiliser chatGPT pour une dizaines de requêtes textuelles, la production d’une image fixe et d’une vidéo courte équivaut, sur le plan énergétique, à faire fonctionner un four microonde pendant trois heures et demie.

Cependant, la fenêtre de contexte des IA pourrait s’agrandir, à moindre coût, en intégrant non pas des mots… mais des images. C’est ce qu’a récemment démontré l’entreprise chinoise Deepseek, avec son prototype Deepseek-OCR. La découverte de ce résultat de recherche, publié en novembre dernier, m’a fait immédiatement songer au livre de Peter Mendelsund, puisqu’il bat décidément en brèche l’illusion que les IA lisent.

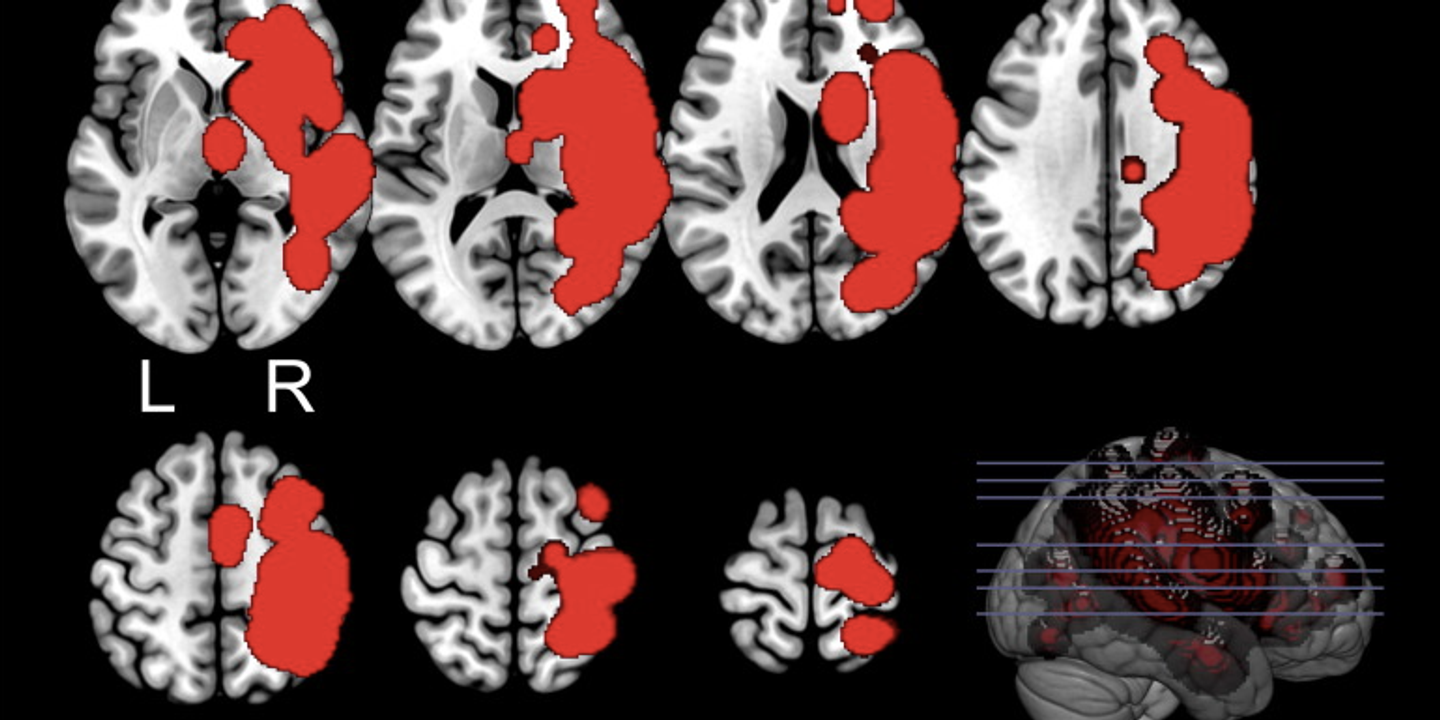

En effet, l’astuce des chercheurs de Deepseek consiste à ne pas considérer le texte comme une organisation de mots, mais… comme une image. Laquelle est compressée, stockée, et utilisée ensuite par le modèle pour reconstruire le texte original, avec une efficacité bien plus grande : il suffit de 100 vision tokens (des échantillons d’image compressés) pour reconstituer environ 800 mots, et maintenir 97 % de la précision du texte initial.

L’information portée par les mots est ainsi stockée dans les pixels. La mémoire de travail de l’IA est d’abord visuelle, plutôt que textuelle. Ce qui donne au modèle, au passage, une meilleure capacité à traiter des documents qui ne sont pas composés que de texte (tableaux, graphiques…).

Si on doutait encore, voilà qui atteste que les IA n’ont décidément ni capacité ni intérêt à lire, au sens où nous, humains, lisons. Surtout, voilà un signe fort que l’avenir de l’IA ne se joue pas seulement sur le terrain de l’hégémonie capitalistique (qui aura le plus grand nombre de datacenters, les puces les plus puissantes, un accès privilégié aux infrastructures énergétiques), mais aussi sur celui de la recherche en informatique. Les futurs modèles d’IA pourraient demain être très différents de ceux qui, aujourd’hui, font le succès des majors du secteur.

il y a 9 hour

3

il y a 9 hour

3

English (US) ·

English (US) ·